Jupyter Notebook + GIS:打造可交互、可复现的空间分析报告

大家好,我是Dr. Gis。在过往十多年的职业生涯里,无论是在规划设计院还是在互联网大厂,我经常被问到一个问题:“博士,我们做的这个GIS分析报告,每次甲方爸爸提个小修改,比如换个数据、调个参数,我们是不是都得从头到尾重新点一遍软件,截图、制图、再写报告?太痛苦了!”

这个问题,精准地道出了我们传统GIS工作流的一大痛点:“一次性”和“不可复现性”。我们的分析过程,高度依赖于鼠标在ArcGIS或QGIS界面的复杂点击操作,这个过程就像一位大厨凭着肌肉记忆炒菜,虽然这次味道不错,但下一次想完全复刻,几乎不可能。而分析报告,往往是Word、PDF、图片这些“静态产物”的拼凑,数据、分析过程、最终结论是割裂的。

今天,我想和大家探讨一种能彻底改变这一窘境的现代化工作流:将强大的Jupyter Notebook与Python GIS技术栈相结合,打造真正可交互、可复现的空间分析报告。这不仅仅是换个工具,更是一种思想上的升维。让我们一起开启这段旅程吧。

总而言之,Jupyter Notebook将我们的分析报告从一份“静态的总结陈词”变成了一本“动态的、可交互的实验手册”。

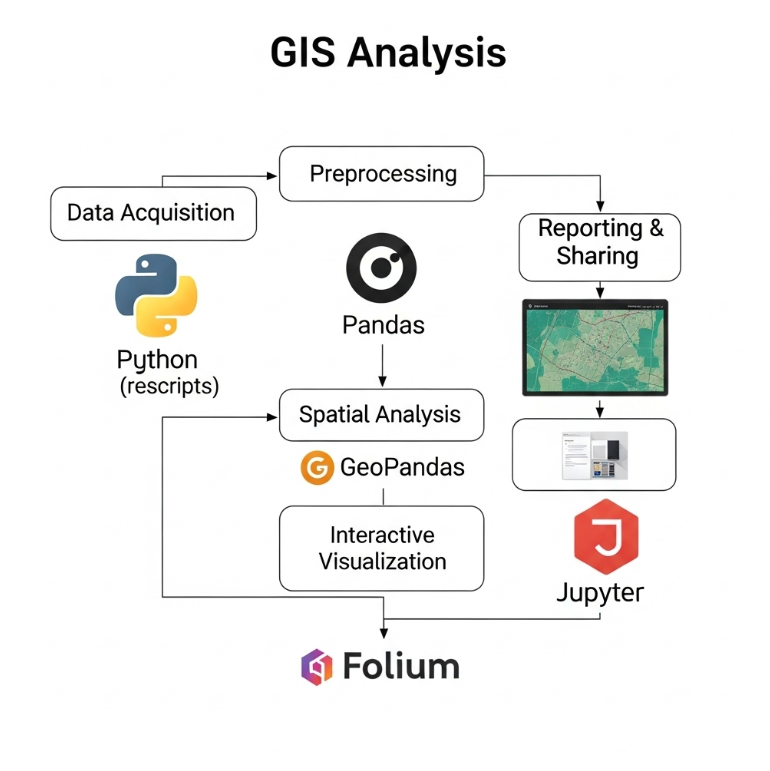

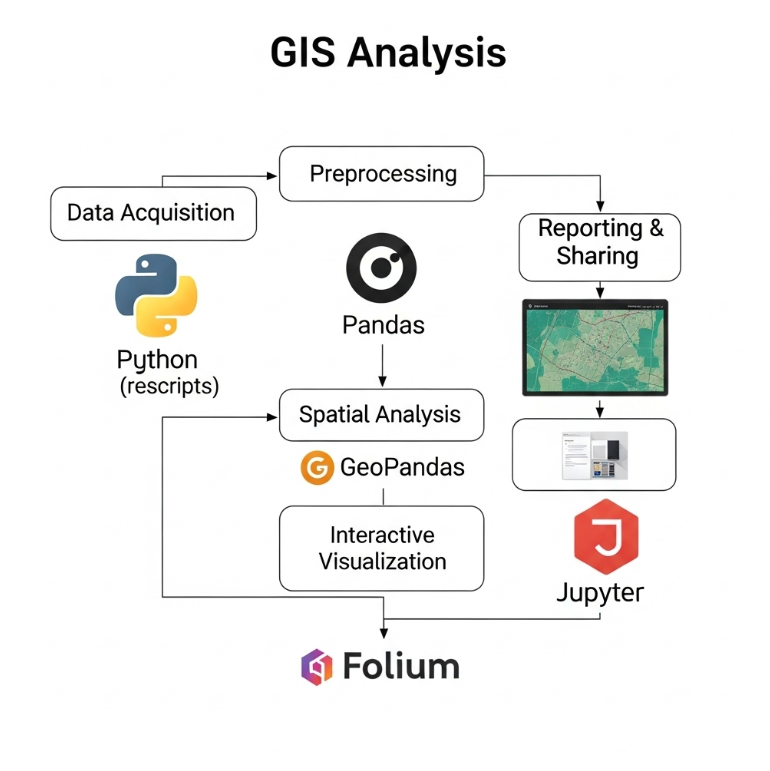

图1:现代GIS分析工作流示意图

图2:公园绿地15分钟步行服务范围可视化

图3:Jupyter Notebook分享方案对比

为什么选择Jupyter Notebook进行空间分析?

在我们习惯了ArcGIS Pro或QGIS的图形用户界面(GUI)后,转向一个满是代码的“笔记本”似乎是一种倒退。但请相信我,这更像从手动挡汽车升级到具备自动驾驶能力的智能汽车。Jupyter Notebook的核心优势,恰好解决了我们前面提到的痛点。核心思想转变: 从 “我做了什么分析” (what I did) 转换到 “我是如何做的分析” (how I did it)。前者是结果的陈述,后者是过程的再现。我们可以用一个表格来直观对比:

| 特性 | 传统GIS软件 (ArcGIS, QGIS) | Jupyter Notebook + Python GIS |

|---|---|---|

| 可复现性 | 低。依赖手动操作日志和记忆,参数调整后需重做。 | 极高。代码、数据和参数清晰记录,一键即可重现整个分析过程。 |

| 自动化 | 依赖ModelBuilder或独立的ArcPy脚本,与报告割裂。 | 原生支持。整个报告就是一个可执行的程序,轻松实现批量处理和自动化更新。 |

| 知识共享 | 困难。分享的是零散的.mxd/.qgz文件和最终报告,分析逻辑难以传递。 | 简单。一个.ipynb文件就封装了代码、可视化结果和文字说明,是完美的知识载体。 |

| 生态系统 | 局限于厂商提供的工具箱。 | 无缝对接整个Python数据科学生态(Pandas, Scikit-learn, PyTorch等),可实现更复杂的分析。 |

核心技术栈:构建现代Python GIS分析环境

要施展Jupyter Notebook的魔法,我们需要一套称手的“魔杖”——也就是Python的地理空间分析库。经过多年的发展,Python的GIS生态已经非常成熟。我将它们分为三类:- 矢量数据处理 (Vector Data): 这是处理点、线、面数据的核心。

geopandas: 绝对的王者。它将pandas(Python数据分析的事实标准)的强大能力赋予了地理空间数据,让我们可以用操作Excel表格的方式来处理Shapefile和GeoJSON。pysal: 专业的空间统计分析库,包含了丰富的空间自相关(如Moran's I)、空间聚类和空间计量经济学模型。

- 栅格数据处理 (Raster Data): 用于处理遥感影像、数字高程模型(DEM)等。

rasterio: 栅格数据读写和基础操作的基石,是对GDAL库的友好封装。xarray-spatial: 提供了更高级的栅格分析功能,如坡度、山体阴影、视域分析等,并且性能很高。

- 交互式可视化 (Interactive Visualization): 这是报告“活”起来的关键。

folium: 基于流行的Leaflet.js库,可以轻松创建可缩放、可平移的交互式地图,并添加标记和弹出窗口。geopandas的.explore()方法默认就使用它。kepler.gl/pydeck: 面向大规模数据集的高性能可视化库,能够流畅渲染百万级的点线数据,并支持3D可视化。

可复现分析的工作流:从数据到报告

一个标准的可复现空间分析报告,通常遵循一个清晰的逻辑链条。我们可以将其概括为以下五个步骤,这套流程也是我自己在项目中沉淀下来的最佳实践。

- 数据获取 (Data Acquisition): 通过API(如使用

osmnx获取OpenStreetMap数据)或直接读取本地文件(使用geopandas.read_file)来加载数据。 - 数据预处理 (Preprocessing): 这是至关重要的一步,包括数据清洗、坐标系转换 (CRS Transformation)、字段计算、几何修复等。

- 核心空间分析 (Spatial Analysis): 执行具体的分析任务,如缓冲区分析 (Buffering)、空间连接 (Spatial Join)、网络分析 (Network Analysis)、密度分析 (Density Analysis) 等。

- 交互式可视化 (Interactive Visualization): 将分析结果(包括中间过程)以交互式地图或图表的形式呈现出来,便于探索和理解。

- 报告撰写与分享 (Reporting & Sharing): 用Markdown语法撰写文字说明,将代码、可视化结果和文字说明组织成一个有机的整体,最终导出一个可分享的报告。

案例实战:城市公园绿地可达性分析

以上海提出建设“千园之城”为背景,我们来模拟一个典型的规划分析任务:评估中心城区公园绿地的15分钟步行服务覆盖范围,并识别服务盲区。这个案例将完美展示Jupyter Notebook的威力。第一步:环境准备与数据获取

我们首先需要获取研究区域的建成区数据、公园绿地数据、以及步行路网数据。在开源世界里,OpenStreetMap (OSM) 是我们的宝库,而osmnx库则是开启这个宝库的钥匙。

# 导入必要的库

import osmnx as ox

import geopandas as gpd

# 定义研究区域 (例如:上海市黄浦区)

place_name = "Huangpu District, Shanghai, China"

# 使用osmnx获取公园绿地数据

tags = {"leisure": "park"}

parks = ox.features_from_place(place_name, tags)

# 获取步行路网数据

G = ox.graph_from_place(place_name, network_type='walk')

第二步:空间分析 - 计算可达范围

我们的核心任务是计算每个公园的15分钟步行等时圈。这里需要用到networkx(一个强大的图论库,osmnx底层依赖它)和geopandas。

- 将公园的几何中心点作为步行起点。

- 遍历路网中的每个节点,计算从该节点到最近公园起点的最短步行时间。

- 生成覆盖所有可达节点的凸包(Convex Hull)或Alpha Shape,作为公园的服务范围。

import networkx as nx

from shapely.geometry import Point, Polygon

# 假设平均步行速度为 4.5 公里/小时

walk_speed_mps = 4.5 * 1000 / 3600 # 米/秒

# ... (此处省略将公园中心点对齐到路网节点、并计算等时圈的详细代码) ...

# 最终,我们会得到一个GeoDataFrame,其中每个多边形代表一个公园的15分钟步行服务范围

# isochrone_polys = ...

第三步:结果可视化与洞察

最后,我们将服务范围、公园位置、以及未被服务的建成区叠加到交互式地图上,一目了然地识别出服务的薄弱环节。保障科学性的基石:可复现环境的最佳实践

仅仅分享一个.ipynb文件,还不足以保证100%的可复现性。您的同事在另一台电脑上可能因为缺少某个库,或者库的版本不一致,导致代码无法运行。这在协作中是致命的。

最佳实践是使用Conda进行环境管理,并分享环境配置文件。

打个比方:创建一个环境并导出配置文件非常简单:.ipynb文件是菜谱,而Conda环境配置文件 (environment.yml) 则是包含了所有厨具品牌、型号和调味品精确克数的清单。只有两者结合,才能保证任何人在任何地方都能做出味道完全一样的菜肴。

# 1. 创建一个新的conda环境

conda create -n gis_env python=3.9

# 2. 激活环境

conda activate gis_env

# 3. 安装所有需要的库

conda install -c conda-forge geopandas osmnx folium jupyterlab

# 4. 从当前环境导出配置文件

conda env export > environment.yml

.ipynb文件和这个environment.yml文件一起分享给同事。对方只需一条命令conda env create -f environment.yml,就能完美克隆您的分析环境。

成果的发布与共享:从静态文件到Web应用

当分析报告完成后,我们如何将其交付给项目经理、客户甚至公众呢?Jupyter提供了多种“打包”方式。- 静态HTML: 最简单的方式。可以直接将Notebook导出为HTML文件。地图的缩放平移交互性得以保留,但所有需要Python后端计算的控件(如滑块)会失效。

- NBViewer: 一个免费的Web服务,可以渲染托管在GitHub等处的公开Notebook。非常适合快速、只读的分享。

- Voila: 这是一个游戏规则的改变者。Voila可以将您的Notebook转换成一个独立的Web应用。与静态导出不同,Voila会保持一个活跃的Python内核在后端运行。这意味着您在Notebook中使用的交互式控件(如

ipywidgets制作的下拉菜单或滑块)在网页上是“活”的,用户可以通过操作控件,动态地触发后端代码重新计算并更新地图和图表。这使得交付一个真正的“交互式数据产品”成为可能。

挑战、解决方案与未来展望

当然,这套技术栈也并非完美。最大的挑战在于性能。当处理百万、甚至千万级别的矢量数据时,geopandas可能会因内存限制而变得缓慢。幸运的是,社区已经提供了解决方案:Dask-GeoPandas。

Dask是一个并行计算库,Dask-GeoPandas则将其能力赋予了geopandas。它会将一个大的GeoDataFrame切分成多个小的分区(Partitions),然后用多个CPU核心并行处理这些分区。代码改动极小,但性能提升巨大。

# 使用GeoPandas进行空间连接 (可能很慢)

gpd.sjoin(large_gdf1, large_gdf2)

# 使用Dask-GeoPandas进行并行空间连接

import dask_geopandas

ddf1 = dask_geopandas.from_geopandas(large_gdf1, npartitions=4)

ddf2 = dask_geopandas.from_geopandas(large_gdf2, npartitions=4)

# 计算结果,Dask会在后台并行处理

result = ddf1.sjoin(ddf2).compute()

scikit-learn进行空间聚类、回归预测,或者集成PyTorch/TensorFlow进行遥感影像的深度学习地物分类。这条路径充满了无限的可能性。

总结

从今天讨论中,我们可以看到,将Jupyter Notebook引入GIS工作流,带来的不仅仅是工具的更替,更是一场深刻的范式革命。它推动我们从“手工作坊式”的制图员,向“工程师思维”的数据科学家转型。 通过构建标准化的技术栈、遵循清晰的工作流、拥抱交互式可视化、并坚守可复现的环境管理,我们可以创造出兼具科学严谨性与动态探索性的新一代空间分析报告。这不仅极大地提升了我们的工作效率和成果质量,也让我们能够更好地与同行、与决策者进行沟通,最大化我们空间分析的价值。 那么,在您的工作中,有哪些重复性的分析任务最适合用Jupyter Notebook来自动化呢?或者您对这套技术栈还有哪些疑问?欢迎在评论区分享您的想法,我们一起探讨!参考文献

- GeoPandas Official Documentation

- OSMnx Official Documentation

- PySAL Official Website

- Rasterio Official Documentation

- Voilà Official Documentation

- Dask-GeoPandas Official Documentation

相关文章

-

gis python 开发入门全解析,gis Python新手指南 2025-09-06 12:13:26

-

gis python开发者必看,gis Python基础入门全解析 2025-09-06 12:13:25

-

gis Python入门指南,从解析gis python基础知识谈起 2025-09-06 12:13:24

-

gis Python入门指南,从解析Gis python库开始 2025-09-06 12:13:23

-

GISer的Python学习路径:从基础语法到GeoPandas空间数据分析 2025-08-23 12:53:35

-

GeoPandas实战:用几行代码完成空间数据读写、坐标转换与可视化 2025-08-19 11:03:19

热门标签

最新资讯

2026-03-01 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02

2026-02-28 08:30:02